Thésée Technologies, une société innovante

Nous proposons aux entreprises d’analyser l’ensemble des pages de leurs sites web afin d’identifier celles qui nécessitent la mise à jour des mentions légales et des formulaires de collecte de données personnelles, pour être en règle avec la nouvelle réglementation sur la protection des données personnelles RGPD - GDPR, le 25 mai 2018.

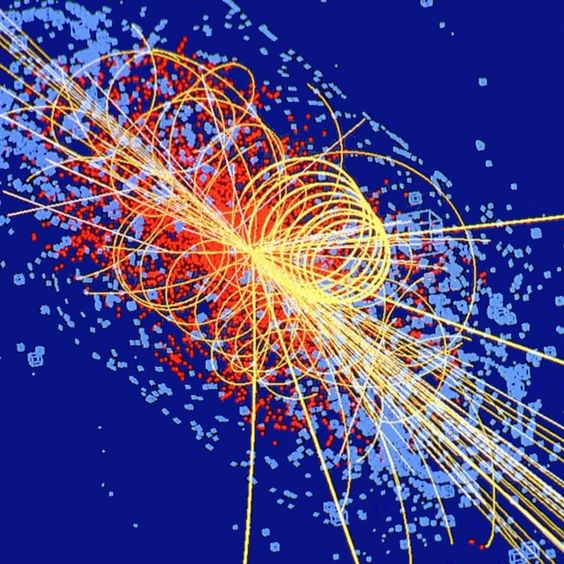

Nous avons développé un robot logiciel qui va parcourir l’ensemble des pages de tous vos sites, comme si nous explorions un arbre en partant du tronc et en passant dans toutes les branches pour aller jusqu’aux feuilles, afin de détecter les informations que nous cherchons.

Ce logiciel a été développé par nos informaticiens qui cumulent plus de 50 années d'expérience dans le web. Ils ont mis leurs expériences et leur créativité pour inventer ce robot logiciel utilisant plus de 20 algorithmes différents.

La cartographie peut être réalisée en quelques jours pour permettre ensuite aux entreprises de mettre leurs pages en conformité avec la nouvelle réglementation.

L'analyse se fait de façon non intrusive, sans installation d'un programme dans votre SI.

Nous utilisons les technologies Open Source de la stack LAMP, si vous ne connaissez pas cet acronyme, vous pouvez lire ceci: Technologie LAMP - wikipedia. Nous stockons les données dans une base dite NoSql, car selon les pages parcourues, nous ne savons pas à l'avance ce qu'il y aura à capturer, indexer et stocker. Nous utilisons des technologies de bases de données que nous avons pratiquées pour d'autres projets "Big Data" dans le passé, en l'occurence MongoDB. Dans le cadre de notre service Minotaure, nous pouvons exporter en format JSON l'ensemble de ce qui aura été détecté et stocké pour un retraitement avancé fait par vos services informatiques par exemple (DataViz avec Tableau possible sur de larges volumétries de dizaines ou centaines de milliers de pages web). Nous consulter directement pour cela sur notre page Devis.

L'hébergement sécurisé en France est fait par OVH - hébergement éco responsable, leader français et maintenant Européen. Nous disposons de plusieurs serveurs distincts, à des fins de développement et de production, et de backup journaliers.

Nous avons développé un robot logiciel qui va parcourir l’ensemble des pages de tous vos sites, comme si nous explorions un arbre en partant du tronc et en passant dans toutes les branches pour aller jusqu’aux feuilles, afin de détecter les informations que nous cherchons.

Ce logiciel a été développé par nos informaticiens qui cumulent plus de 50 années d'expérience dans le web. Ils ont mis leurs expériences et leur créativité pour inventer ce robot logiciel utilisant plus de 20 algorithmes différents.

La cartographie peut être réalisée en quelques jours pour permettre ensuite aux entreprises de mettre leurs pages en conformité avec la nouvelle réglementation.

L'analyse se fait de façon non intrusive, sans installation d'un programme dans votre SI.

Nous utilisons les technologies Open Source de la stack LAMP, si vous ne connaissez pas cet acronyme, vous pouvez lire ceci: Technologie LAMP - wikipedia. Nous stockons les données dans une base dite NoSql, car selon les pages parcourues, nous ne savons pas à l'avance ce qu'il y aura à capturer, indexer et stocker. Nous utilisons des technologies de bases de données que nous avons pratiquées pour d'autres projets "Big Data" dans le passé, en l'occurence MongoDB. Dans le cadre de notre service Minotaure, nous pouvons exporter en format JSON l'ensemble de ce qui aura été détecté et stocké pour un retraitement avancé fait par vos services informatiques par exemple (DataViz avec Tableau possible sur de larges volumétries de dizaines ou centaines de milliers de pages web). Nous consulter directement pour cela sur notre page Devis.

L'hébergement sécurisé en France est fait par OVH - hébergement éco responsable, leader français et maintenant Européen. Nous disposons de plusieurs serveurs distincts, à des fins de développement et de production, et de backup journaliers.